看到标题你肯定认为今天西风seo为你讲的是seo伪原创的一些问题,你错了,今天的主题是搜索引擎的一个算法:“去重”,我们大家肯定是伪原创的领导者,因为网络优化的话,不可能是一直是同一行业,原创的话自己不懂,只能伪原创,这样真的能有排名吗?如果没有为什么?

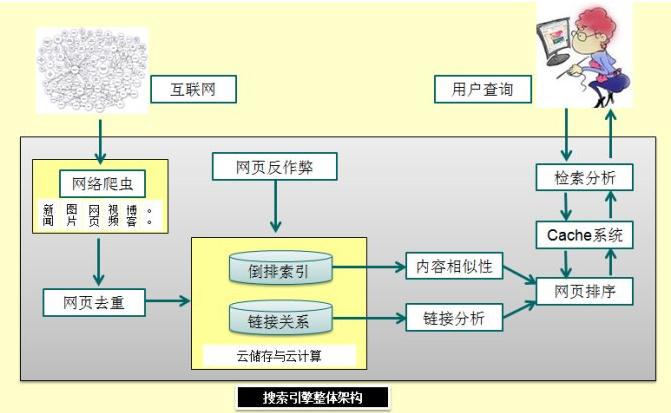

互联网中存在了大量的重复页面,据统计表明近似重复页面的数量占据网站总数量的29%,而完全重复页面占据了22%。这些重复的页面对搜索引擎来说占据了很多的资源,因此搜索引擎对页面的去重也是搜索引擎中很重要的一个算法。

去重概念

相同文章是各大搜索引擎不喜欢的,百度站长平台中有“原创保护”,原创对搜索引擎是有很大好处的,用户不喜欢过时的、重复的,当你搜索时,如果搜索引擎给你看到的是大量重复的文章,这种体验是不好的。搜索引擎会对重复的内容进行识别和删除,然后返回相同文章中的一篇,这就是“去重”。

去重的方法是根据关键词指纹来计算,选择一个最具有代表意义的关键词然后再分词和去停止词去噪之后在选择10个特征这样就可以到达一个非常高的准确性,特征再多了不但浪费计算并且没有意义,简单的加一些的地得已经让我们知道这样所谓的伪原创对付搜索引擎木有任何的意义。搜索引擎的去重不会只是淡淡的一个页面或者一个网站,而是在整个互联网都在运作,是以所谓的调换段落,和用几篇文章拼成一篇文章的做法并不能让搜索引擎认为这是原创文章。

内容重复可以归结为以下4种类型。

类型一:如果两篇文档内容和布局格式上毫无差别,则这种重复可以叫做完全重复页面。

类型二:如果两篇文档内容相同,但是布局格式不同,则叫做内容重复页面。

类型三:如果两篇文档有部分重要的内容相同,并且布局格式相同,则称为布局重复页面。

类型四:如果两篇文档有部分重要的内容相同,但是布局格式不同,则称为部分重复页面。

如果内容重复了,是不是搜索引擎就进行收录索引了,答案是否定的,只是搜索引擎会根据网站的整体权重适当给予索引标准,但是是否这样就可以一直采集和伪原创了,一定不要这样做,搜索引擎会定期跟进算法标准,对采集和大量无效内容进行打击,最后进行降权处理。

展示大量重复的信息对用户并不是最好的体验,照成这这种肯能的愿因有镜像网站、内容复制、嵌入广告、计数改变、少量修改等问题,从问题中我们可以得出搜索引擎去重的优点:

优点一:

如果我们能够找出这些重复网页并从数据库中去掉,就能够节省一部分存储空间,进而可以利用这部分空间存放更多的有效网页内容,同时也提高了搜索引擎的搜索质量和用户体验。

优点二:

通过对以往收集信息的分析,预先发现重复网页,在今后的 网页收集过程中就可以避开这些网页,从而提高网页的收集速度。有研究表明重 复网页随着时间不发生太大变化,所以这种从重复页面集合中选择部分页面进行 索引是有效的。

优点三:

如果某个网页的镜像度较高,往往是其内容比较受欢迎的一种间接体现也就预示着该网页相对重要,在收集网页时应赋予它较高的优先级,而当搜索引擎系统在响应用户的检索请求并对输出结果排序时,应该赋予它较高的权值。

优点四:

另外一个角度看,如果用户点击了一个死链接,那么可以将用户引导到一个内容相同页面,这样可以有效地增加用户的检索体验。因而近似重复网页的及时发现有利于改善搜索引擎系统的服务质量。

搜索引擎去重基于的算法汇总

每个搜索引擎判断重复性内容的方法都不太一样,一般都是基于以下算法实施的。算法提取的信息不是针对整张网页,而是把网站里面共同的部分如导航条、logo、版权等信息(这些称之为网页的“噪音”)过滤掉后剩下的文本。

计算信息指纹(Fingerprint)的算法

信息指纹就是把网页里面正文信息,提取一定的信息,可以是关键字、词、句子或者段落及其在网页里面的权重等,对它进行加密,如MD5加密,从而形成的一个字符串。信息指纹如同人的指纹,只要内容不相同,信息指纹就不一样。

分段签名算法

这种算法是按照一定的规则把网页切成N段,对每一段进行签名,形成每一段的信息指纹。如果这N个信息指纹里面有M个相同时(m是系统定义的阙值),则认为两者是复制网页。

这种算法对于小规模的判断复制网页是很好的一种算法,但是对于像百度这样海量的搜索引擎来说,算法的复杂度相当高。

I-Match算法

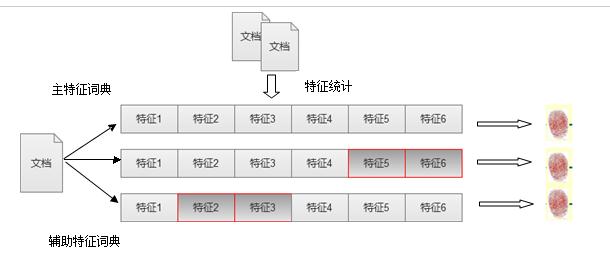

对于I-Match算法来说主要是根据大规模的文本集合进行统计,对于文本中出现的所有单词,按照单词的IDF(逆文本词频因子)来进行由高到低的排序,除去得分最高和得分最低的单词,保留剩下的单词最为特征词典。这一步骤主要是删除文本中无关的关键词,保留重要关键词。下面是I-Match流程示意图:

I-Match算法

获得全局特征词典之后,对需要去重的页面,扫描下就能获得该页面上出现的所有单词,对于这些单词根据特征词典过滤:保留在特征词典上出现的单词,用来表达文档的主要内容,删除没有在特征词典中出现的内容。提取出对应的特征词之后在利用哈希函数对特征词汇进行哈希计算,获得的数值就是该文档的文本指纹。

所有文档都统计完之后如果想查看两篇文档是否重复只需要查看文档的文本指纹是否近似,如果近似则表示两篇文档重复。这样的比对方式很直观而且效率也很高,去重效果比较明显。

重点:传统的伪原创文章,对一篇文章进行简单的修改,首尾做一些小的变动,然后把中间段落调整顺序,这个对搜索引擎来说都是没有意义的,还是可以判断出两篇文章是否重复。因为我们对于文章的建设还是要原创,或者对原文章进行比较大的改动,使两篇文章的特征词典发生改变。

词语解释:

IDF 逆文档词频因子:衡量一个词普遍重要度的衡量因子,某一特定词语的IDF,可用总文件数目除以含有该词语文档数目,将得到的商取对数得到。

基于关键词的复制网页算法

像google这类搜索引擎,他在抓取网页的时候都会记下以下网页信息:

1、网页中出现的关键词(中文分词技术)以及每个关键词的权重(关键词密度);

2、提取meta descrīption或者每个网页的512个字节的有效文字。

关于第2点,baidu和google有所不同,google是提取你的meta descrīption,如果没有查询关键字相关的512个字节,而百度是直接提取后者。这一点大家使用过的都有所体会。

simhash算法:

mhash算法,专门用来解决亿万级别的网页的去重任务。simhash作为locality sensitive hash(局部敏感哈希;从海量的高维数据集合中找到与某个数据最相似的一个数据)的一种。

余弦去重

余弦相似度用向量空间中两个向量夹角的余弦值作为衡量两个个体间差异的大小。余弦值越接近1,就表明夹角越接近0度,也就是两个向量越相似,这就叫"余弦相似性",搜索引擎用这个算法来确认网页的相识度。

总结:有以上去重算法为你所写的文章进行检验,除非是你把文章更改的面目全非,否则不会认为你是原创,页面权重会相应的低一点,索引是有的,但是排名有没有这个真不好说了,如何做优质文章呢!

找到相同行业的但是不同种类的原创文章进行更改这就是为了避免算法影响:比如:狗狗,猫猫.,猪猪,动物类的饲养方法,除了吃的不一样,有相同的可以拿来聚合资源啊,因为我们主题不同,客户搜索的主题也不同,相似度就不同了。

“聚合”文章,聚合文章能让文章更加的丰富,比如:产品a,在查询的产品时可以根据搜索引擎下拉,相关搜索,进行整理汇总,这样也是避免重复度高的一种方法。

.原创文章改造,有的人问,原创文章改造不就是伪原创吗? “no”,原文改造,是每一段文字,按照你的意思用“白话”叙述下来,就想老师备课一样,不可能,把要说的话用几张a4纸打印下来,念45分钟吧,列出大纲稍加修饰,一篇原创就出来了。